杀人机器人:危险不科幻

图为科幻电影《终结者》中的金属机器人。CFP

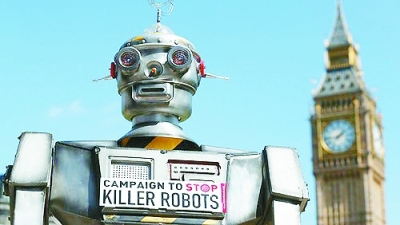

图为民众抗议杀人机器人的研发。资料图片

图为美国的无人机。资料图片

【纵深报道】

2029年,人类和智能机器人之间的一场大战打响:机器人“终结者”奉命杀死约翰·康纳的母亲莎拉·康纳——这是由詹姆斯·卡梅隆于1984年创作的5部系列电影的序曲。科幻作家没有料想到,如今的科技已经可以制造出这样的机器人:它们一旦被授予使命后,会自发地做出杀人甚至暴动的决定。

这些机器人杀手在国际军备讨论中有一个恰如其分的名字:LAWS(Lethal Autonomous Weapons Systems,致命性自主武器系统)。这种机器人已经登上了历史的舞台,将它们带到战场上会引起各种各样的争议:如何定义这些机器人?它们到底能做什么?战场上的伦理问题如何解决?

1942年,著名的美籍俄罗斯裔科幻作家艾萨克·阿西莫夫在《惊奇科幻小说》中提出了机器人的伦理问题,他被世人视为机械伦理学之父。阿西莫夫在1942年出版的小说《转圈圈》中描述了机器人三定律。他提出,所有的机器人程序都必须考虑到这三条定律,目的是为了约束这些自主机器人的行为,让它们服从以保护人类为目的的强制性道德准则。

■阿西莫夫机器人定律

第一定律:机器人不得伤害人类,或坐视人类受到伤害;

第二定律:除非违背第一法则,否则机器人必须服从人类的命令;

第三定律:在不违背第一及第二法则下,机器人必须保护自己。

此后,阿西莫夫又添加了一条定律,即第零定律:机器人不得伤害人类族群,或因不作为使人类族群受到伤害。

机器人遵守这些定律而引发的困局是阿西莫夫所著500本书籍的主题。他严肃地思考了这些定律的意义,并想象了这些定律被采纳时发生的情形。然而时至今日,阿西莫夫关于机械伦理的设想并未如愿:如今的机器人并没有安装强制它们服从机器人定律的机制或指令。为什么会这样呢?

■无法服从机器人定律

现在的机器人拥有的功能和人们当初设想的不太一样。科技并没有让我们凭空创造出和自己一样的东西,我们并不能像对待奴隶或佣人那样指使它们。机器人以及智能系统的产生并非一蹴而就,因为科技总是沿着意想不到的方向前进。这样一来,如何准确区分机器人和智能系统就变得十分棘手。

驾驶飞机平安降落的自主系统能否称为机器人?它是否具有智能?我们很容易得出否定的答案。这个自主系统操作飞机的能力和人类飞行员一样好,而且对自己的方位了如指掌,所以才能让飞机准确降落。虽然它的功能很有限,但在降落飞机这项人命关天的任务上,它和人类相比毫不逊色。

现代社会中机器人的工作非常专业化,它们不具备与人类用通俗语言交流的能力。我们无法要求它们遵守阿西莫夫的机器人定律,因为它们完全不能理解这些定律的意义。如果想要应用机器人定律,智能系统必须具备逻辑分析和推理能力,并且能够预测行为所导致的后果,以判断人类下达的指令是否和任何一条定律相悖。但目前,机器人还不能进行这样的分析。

美国iRobot公司的创始人罗德尼·布鲁克斯曾就上述问题直白地表达了自己的观点。媒体问他,为何iRobot生产的机器人不能自动遵守阿西莫夫定律,他回答,“理由很简单,我们根本没法把阿西莫夫的定律写入它们的系统中。”虽然未来的智能系统可能会随着科技的进步而发展出智力,并且智能系统中负责自主抉择的组件会获得性能提升,但这种机器智力和人类智力仍然不可同日而语。也就是说,科幻作家当初让机器人理解和服从阿西莫夫定律的希望,现在已经变成了一件异想天开的事。但是,这并非意味着讨论机械伦理问题就是多此一举。因为在自动驾驶领域,相关研发已经进行了许多年,多家公司设计的性能稳定的产品也将进入市场,因此讨论机械伦理问题的时机已经成熟。